【引入】

假设下图是一张大小为 $28\times28$ 的黑白图片(单通道),将每一个像素点视为一个特征值,那么该图有 $28\times28=784$ 个特征值

进一步,若这张图片是彩色的,那么其由 RGB 三通道组成,这以为着总共有 $28\times28\times3=2352$ 个特征值

也就是说,对于上面的大小为 $28\times28$ 的彩色图,其输入是 $2352$ 个特征值,对应于神经网络,即输入层有 $2352$ 个神经元,假设第一层隐藏层具有 $10$ 个神经元,那么就有 $2352\times10=23520$ 个连接权重

那么,随着图片尺寸的扩大,使用全连接神经网络处理图片,无疑会带来以下三个问题:

- 将图像展开为向量会丢失空间信息

- 参数过多效率低下,训练困难

- 同时大量的参数很快就会导致网络过拟合

为解决全连接神经网络在处理大尺度图片时的问题,出现了卷积神经网络(Convolutional Neural Networks,CNN),其是指至少在网络的一层中使用卷积运算来代替矩阵乘法的神经网络

【卷积神经网络的发展】

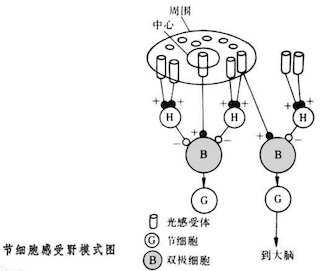

生物学中的感受野

1962 年 Hubel 和 Wiesel 通过对猫视觉皮层细胞的研究,提出了感受野(Receptive Field)这一概念,即:单个感受器与诸多感觉神经纤维相联系,感觉信息是通过诸多感觉神经纤维发放总和性的空间与时间类型不同的神经冲动,即经过编码来传递的

简单来说,一个神经元所反应的刺激区域就叫做神经元的感受野

神经认知机

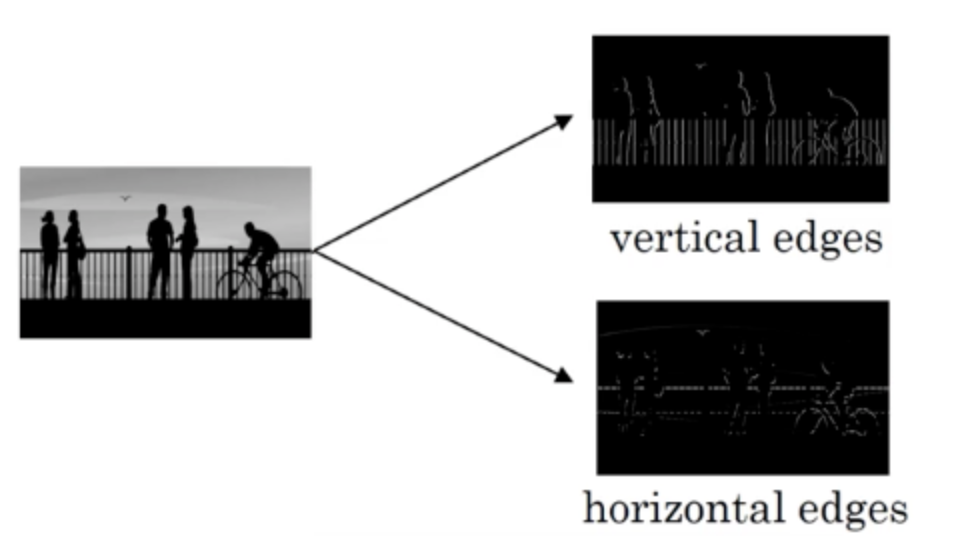

在生物学中感受野的概念基础上,1979 年 Kunihiko Fukushima 提出了神经认知机(Neocognitron),并提出了卷积、池化等基本概念,其被视为卷积神经网络的雏形,其核心思想是:通过设计一个固定大小的滤波器(Filter),分别对图像的同大小区域进行逐部分滤波,最终得出图像特征信息

如下图所示,当设计的滤波器为水平滤波器或垂直滤波器时,可以得到图像的边缘检测信息(Edge Detection Information)

相较于之前的全连接神经网络,通过这种设定固定的大小的感受器对图片进行逐部分识别,极大的减小了网络中的参数,提升了训练速度

卷积神经网络

直到 1989 年,Yann LeCun 提出了一种利用反向传播进行更新的卷积神经网络——LeNet,这被认为是第一个卷积神经网络

1998 年,Yann LeCun 又对 LeNet 进行改进,出现了 LeNet5,此后,卷积神经网络的发展几乎陷于停滞

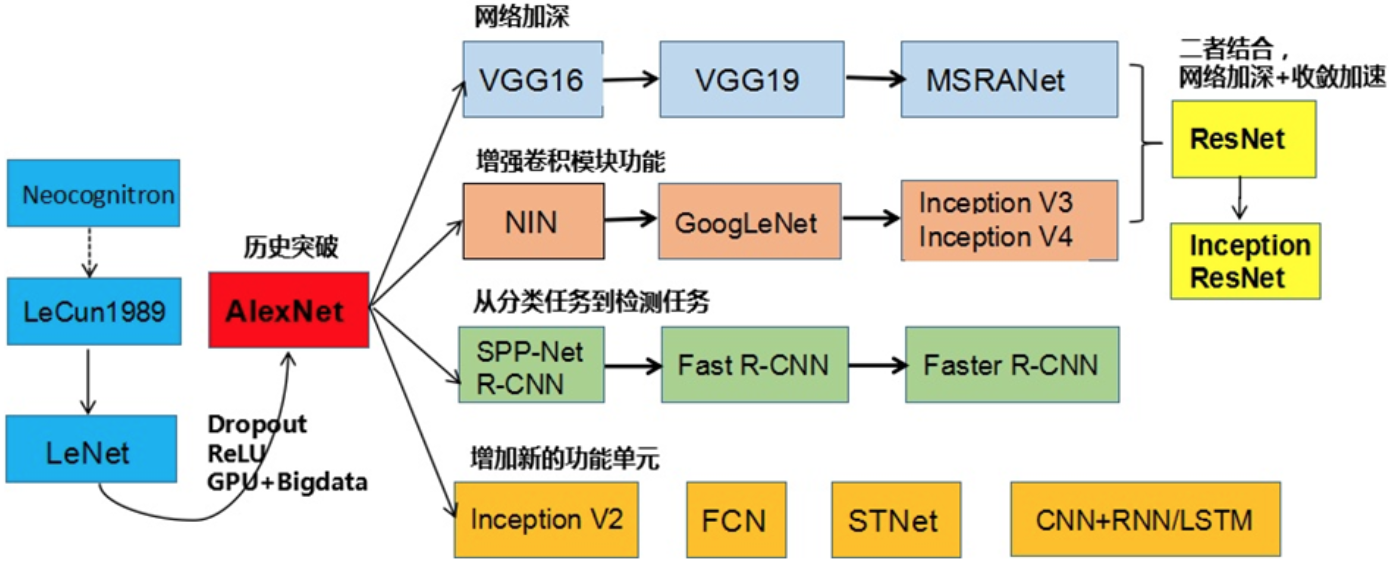

直到 2012 年,AlexNet 横空出世,使得卷积神经网络得到历史性的突破,卷积神经网络开始从网络的加深、卷积模块的增加、从分类任务向检测任务的扩展、新的功能单元等方向迅速发展

关于各经典卷积神经网络的详细介绍,见:

- LeNet-5:经典卷积神经网络之 LeNet-5

- AlexNet:经典卷积神经网络之 AlexNet

- VGG16 与 VGG19:经典卷积神经网络之 VGG

- NIN:经典卷积神经网络之 NIN

- GoogLeNet:经典卷积神经网络之 GoogLeNet

- ResNet:经典卷积神经网络之 ResNet

对于各经典的卷积神经网络,具体的网络结构图在神经网络结构可视化工具 netscope 中有相应示例