References:

【概述】

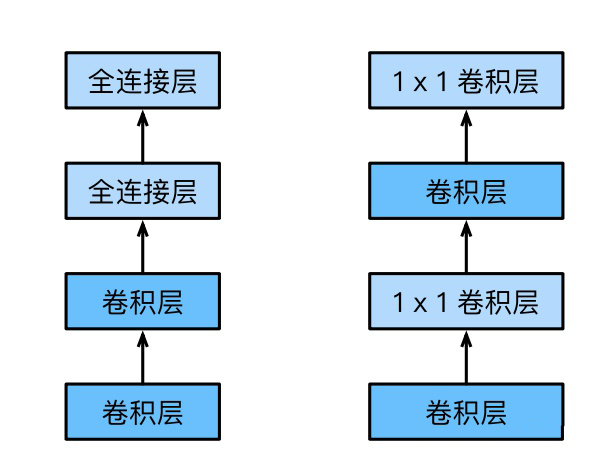

AlexNet 的绝大多数参数都集中在最后几个全连接层上,但全连接层不仅参数多,还具有强线性性,同时还容易发生过拟合

NIN(Network in Network)对传统的卷积特征提取方式进行改进,提出了使用创造性的 MLP 卷积(MLPConv)来代替传统的线性卷积核,并采用全局平均池化(Global Average Pooling,GAP)来代替全连接层

如下图所示,左边为 AlexNet、VGG 结构,右边为 NIN 结构

【贡献】

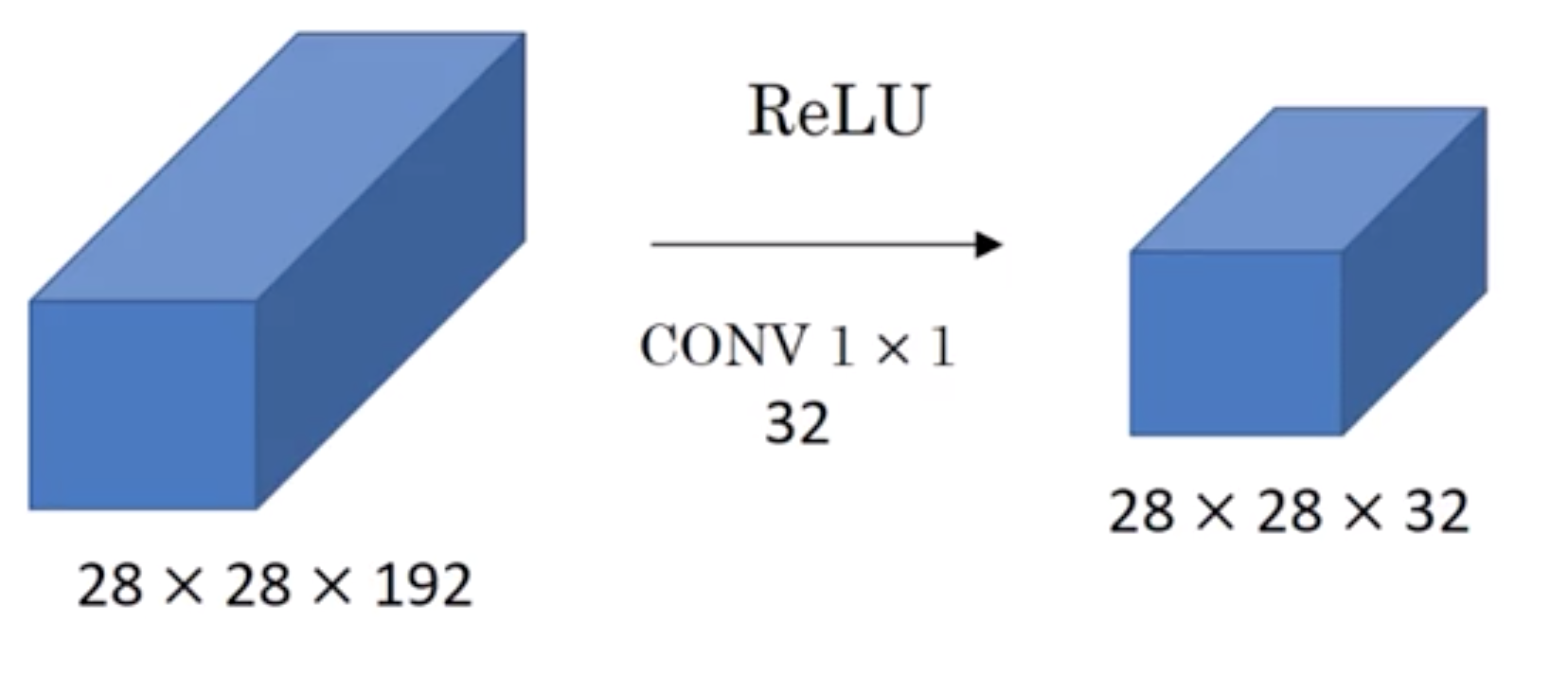

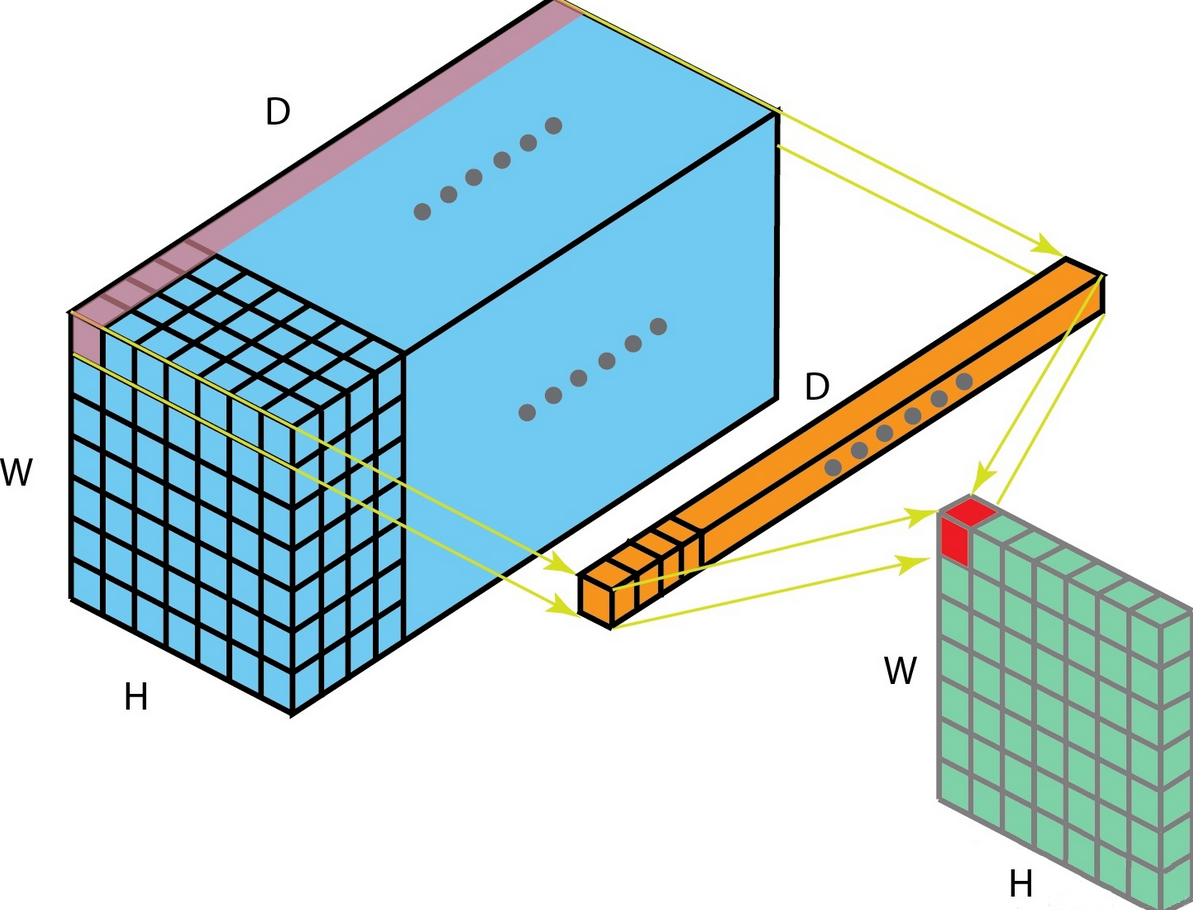

NIN 中使用 MLP 卷积来代替传统的线性卷积核的方式,也被称为 $1\times 1$ 卷积层,其通过利用多个普通卷积层与 $1\times1$ 卷积层的嵌套来代替之前的全连接层,将特征图由多通道的线性组合变为非线性组合,从而提高特征抽象能力

此外,$1\times 1$ 卷积核还可以实现卷积核通道数的降维和升维,实现参数的减小化

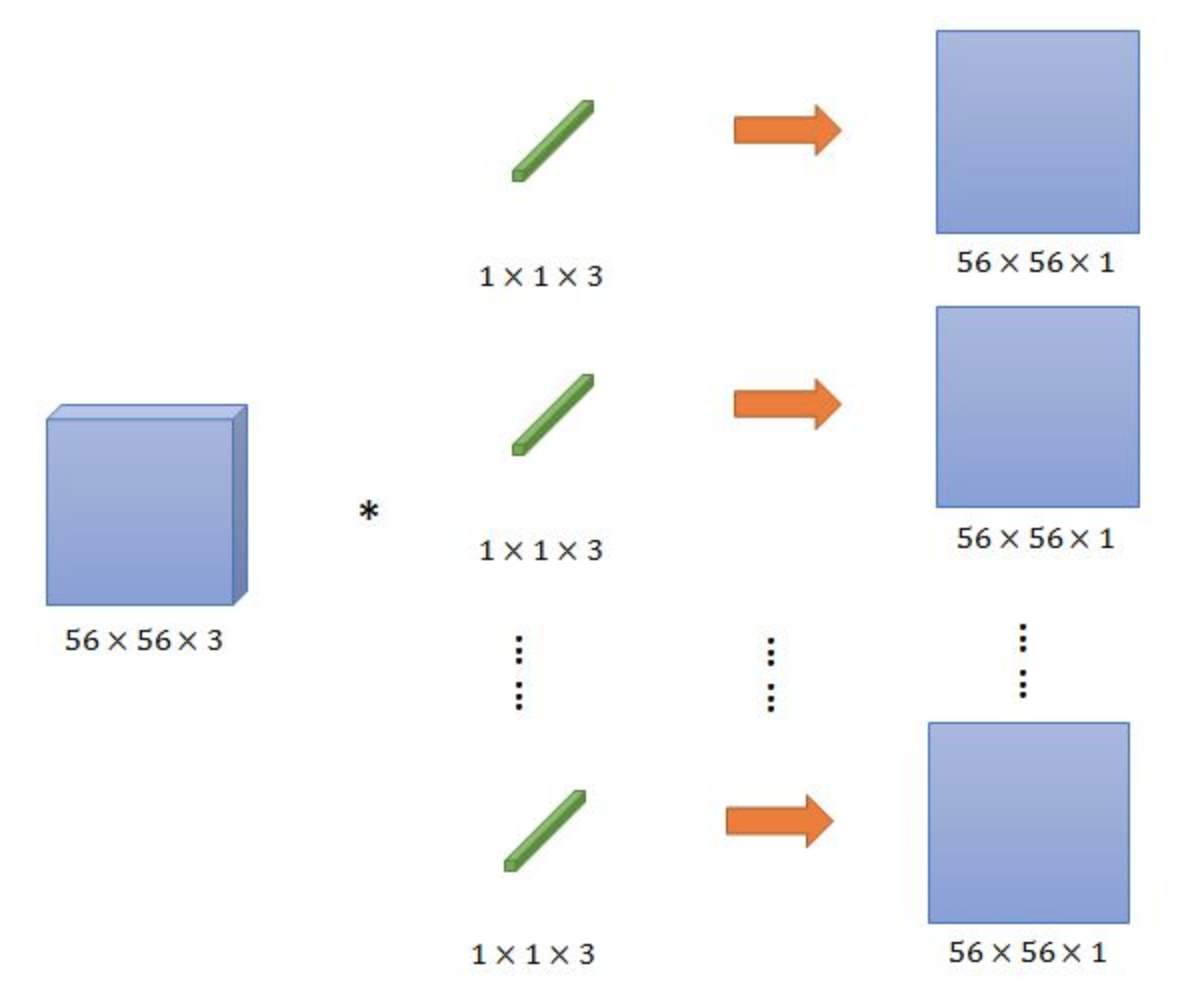

如下图所示,假设对于输入尺度为 $56\times56\times3$ 的图像,存在 $n$ 个 $1\times1$ 的滤波器,那么最终能得到 $n$ 个 $56\times56\times1$ 的图像

换个角度来看,相当于将每个滤波器看作神经元结构,每个神经元参数数量与前面的通道数相同,在加入激活函数后,可以认为是一个简单的 MLP

也就是说,每一个滤波器相当于一个参数,可以看做是对 $n$ 个通道进行了线性组合

事实上,$1\times 1$ 卷积能够改变通道数并不是其最重要的特点,因为 $3\times3$、$5\times 5$ 等卷积核都可以带来通道数的变化,其最大的优点是相较于其他卷积核,$1\times 1$ 卷积的参数少